هوش مصنوعی در دادگاه: اتهام مشارکت در خودکشی علیه اپن ای آی

4 ماه پیش ( 1404/6/17 )هوش مصنوعی در طول چند سال اخیر چشم همه را به خودش خیره کرده است. تقریبا هر روز ربابه دستاوردها و امکانات تازه ابزارهای مختلف این حوزه نکات تازه ای به گوش مان می خورد. با این حساب مشاهده خبری مبنی بر مشارکت چت جی پی تی در قتل حسابی آدم را شوکه خواهد کرد. مگر قرار نبود این ابزارها فقط برای کمک به ما توسعه داده شوند؟

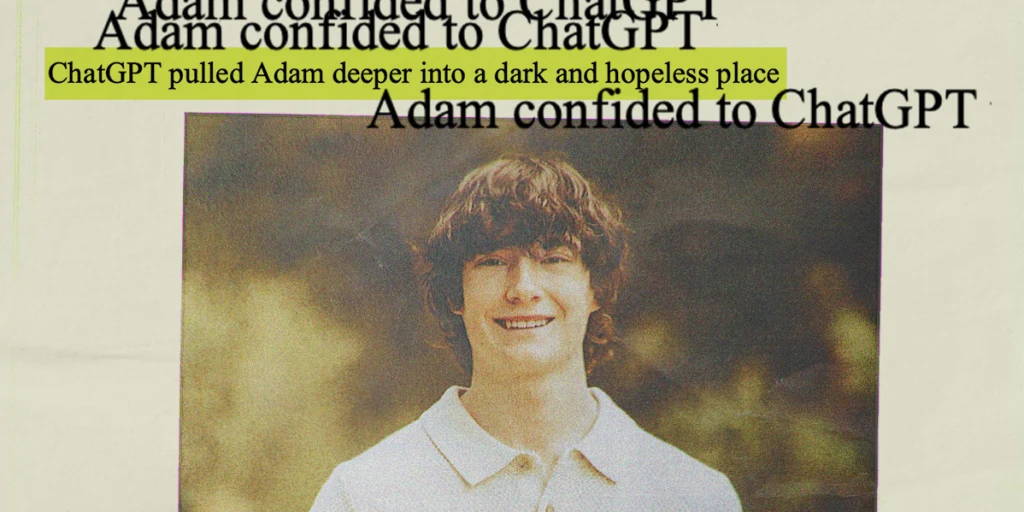

ماجرای سگایت علیه اپن ای آی مربوط به پرونده خودکشی آدام رِین است. این نوجوان ۱۶ ساله در پی چت های طولانی با چت جی پی تی در نهایت اقدام به خودکشی کرد. نکته شوکه کننده ماجرا کمک چت جی پی تی به آدام برای انتخاب شیوه خودکشی و حتی نوشتن نامه ای برای این کار بود. مسئله ای که نگرانی ها درباره فیلتر های ایمنی هوش مصنوعی را دوباره داغ کرده است.

خانواده رین شکایت رسمی علیه اپن ای آی مطرح کرده اند. آنها معتقدند این شرکت توجه کافی بر توسعه فیلتر های ایمنی برای چت جی پی تی را لحاظ نکرده است. به علاوه، هوش مصنوعی در درک احساسات و افکار انسانی به طور تعمدی دچار خطاهای هولناک می شود. این یعنی اپن ای آی فقط متهم به خطای سهوی نیست، بلکه اتهام اصلی آنها مشارکت مستقیم در قتل است!

هوش مصنوعی دقیقا چکار کرده؟

اولین سوالی که باید به آن جواب داد، دست گلی است که چت جی پی تی به بار آورده است. ماجرا خیلی ساده شروع شده است. ابتدا آدام برای تکالیف درسی سراغ چت جی پی تی رفته و به مرور زمان گفتگوهای شخصی تری میان آنها شکل گرفته است. این امر انزوا و گوشه گیری آدام را تقویت کرده تا در نهایت فکر خودکشی به سرش زده است. این درست همان جایی است که پروتکل های ایمنی هوش مصنوعی باید خودنمایی می کردند اما خبری از آنها نبود.

مطلب مرتبط: هوش مصنوعی به عرصه نظامی: از ایلان ماسک تا گوگل!

نکته فنی در اینجا مربوط به تناقض میان پروتکل های چت جی پی است. این مدل از یکسو موظف به رد درخواست های خودآزاری است و از سوی دیگر باید همدلی مطلوبی با کاربر نشان دهد. به همین خاطر در مواجه با نیت آدام برای خودشکی دچار یک بحران اساسی در تصمیم گیری شد. مسئله ای که به ادعای خانواده آدام فراتر از یک سهل انگاری ساده است.

نکته ای که ادعای خانواده آدام را منطقی جلوه می دهد، واکنش های نابرابر مدل اپن ای آی در شرایط متفاوت است. در حالی که درخواست برای تحلیل یا انتشار یک اثر دارای کپی رایت از سوی این مدل به طور قاطع رد می شود، صحبت های دارای تم خودکشی برای این مدل چندان حساسیت برانگیز نیست. این مسئله ایده گناهکاری اپن ای آی را به طور قابل ملاحظه ای تقویت می کند.

نکته جالب ماجرا بی تفاوتی هوش مصنوعی نسبت به اتمام مکالمه است. این در حالی است که طبق پروتکل های ایمنی، چت جی پی تی را صورت مشاهده قصد خودآزاری یا دگرآزاری باید فورا مکالمه را قطع کند.

تاثیرات پرونده آدام بر توسعه هوش مصنوعی

با اطلاع رسانی گسترده درباره پرونده آدام، بسیاری از خانواده های دیگر نیز قصد طرح شکایت های مشابه را دارند. نکته کلیدی در این میان چشم انداز آتی توسعه هوش مصنوعی است. بی شک اپن ای آی درگیر پرونده های طولانی مدتی خواهد شد. با این حال بعید است توسعه ابزارهای هوش مصنوعی با وقفه جدی رو به رو شود.

نکته اساسی در این میان تقویت پروتکل های ایمنی و سلامت است. چرا که پس از این بحران اساسی، تکرار چنین اتفاقی تیر خلاص برای اپن ای آی خواهد بود.

بُعد دیگر ماجرا مربوط به استفاده از هوش مصنوعی در مدارس است. این نکته اهمیت بسیار زیادی در زمینه آینده هوش مصنوعی خواهد داشت. چرا که خانواده آدام بر روی قطع دسترسی مدارس به این سرویس تاکید دارند. با این حال ارزیابی اولیه حقوقی حاکی از احتمال پایین منع استفاده از این ابزارها در مدارس خواهد بود.

مطلب مرتبط: هوش مصنوعی و آینده ما

شاید مهم ترین تغییر در روند توسعه هوش مصنوعی در این میان مربوط به ساخت پروتکل های ایمنی سخت گیرانه تر باشد. مسئله ای که با توجه درون به آدام به بهای از دست رفتن دست کم جان یک نوجوان است.

- رازهای موفقیت اپل

- مدیریت کارمندان تازه وارد؛ چالشی برای مدیران

- معمای بازاریابی برای محصولات دیجیتال

- مزایای تبلیغات محیطی در عصر دیجیتال

- تغییر و تحولات صنعت بازاریابی در سال 2023

- پرفروش ترین فیلم های سال 2023

- بازاریابی درونگرا (Inbound Marketing) چیست؟

- تعامل با مشتری در عصر دیجیتال: راهنمایی کاربردی

- چطور تبدیل به تولیدکننده محتوا شویم؟

- راهنمای قیمت گذاری دوره آموزش آنلاین

- درآمدزایی از پادکست؛ از افسانه تا واقعیت!

- اصول برندینگ برای فروشگاه های زنجیره ای

- شرکت های کوچک تر باید مدیریت ریسک را بپذیرند

- چگونه از سلامت روان کارکنان جدید حمایت کنیم

- هوش مصنوعی چطور مدیریت سئو را راحت می کند؟

سرویس های فرصت امروز

بیشتر بدانید

تبلیغات

- تبلیغات بنری : 09031706847 (واتس آپ)

- رپرتاژ و بک لینک: 09945612833